用户舆情信息包括文本、音频、图片等各种各样的形式,实际工作中我们应用较多的还是文本类的用户舆情。综合考虑数量、丰富性、易获得性、信息匹配度等方面因素,文本之于音视频、图片而言的信息价值、性价比都是相对比较高的。

一、文本用户舆情的价值

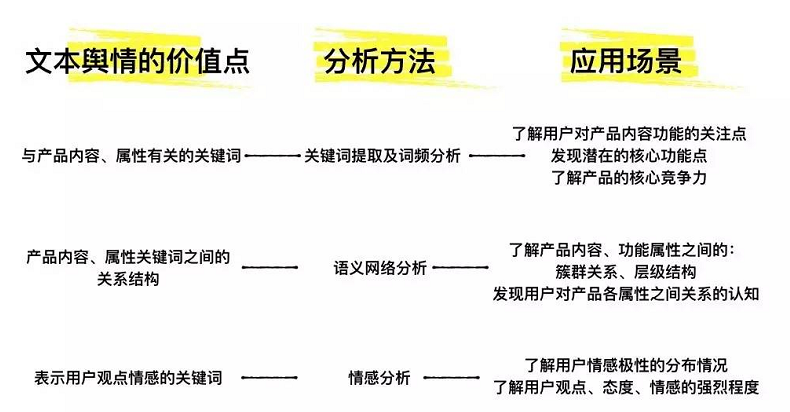

当我们从电商、论坛、应用市场、新闻媒介等渠道平台取到大量和调研目标相匹配的用户舆情文本后,具体应该如何应用?其中可能包含哪些对用研有价值的内容?可以通过什么方法提炼分析?能实现什么预期效果?根据以往项目经验,文本舆情分析的价值和具体应用如下图所示:

这些信息既描述说明了“是什么”的问题,也可以表明属性、关系、喜好,说明是“怎么样”的,还能在一定程度上分析表象背后的原因,分析“为什么”,可以挖掘出包含其中的焦点、趋势、关联,帮助我们了解产品的市场反馈和用户需求,为方向聚焦、策略引导、价值判断提供依据。

二、文本舆情数据的分析方法

分析文本舆情数据,主要用到的是文本分析的方法。因为文本数据是非结构化的,拿到文本舆情之后的一个关键问题是要把数据转化为能被计算机理解和处理的结构化数据,然后才可能进一步对用户舆情数据进行完整系统的处理分析,从无关冗余的数据中提炼出有意义的部分。

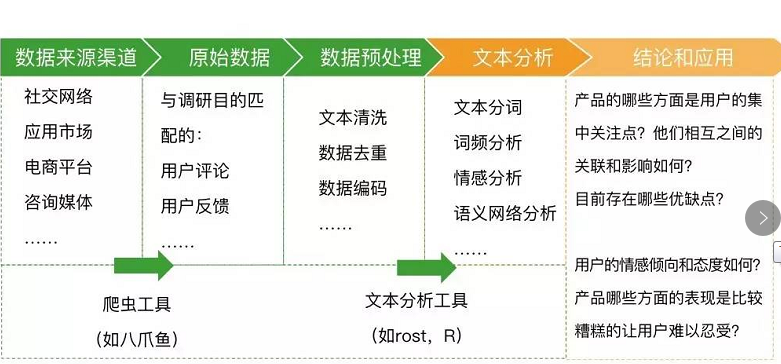

过程中需要用到的工具有:

数据爬虫工具:可以根据我们的需要免费从网站上爬取数据(在设有反爬虫机制的渠道,获取舆情数据的难度会增加)。文本分析工具:通过分词处理、词频分析、语义网络分析等,挖掘潜藏其中的关键信息,把握深层的关系和结构。根据笔者的实际使用经验,文本分析工具ROST的功能完善,在文本数据量不太大的情况下基本能满足中文舆情分析的需要。如果对于文本分析结果有更高的要求,可使用、R等编程语言进行处理。文本数据可视化工具:使用工具将文本分析结果以可视化的形式(如词云图、语义网络图)呈现出来,便于从中直观的发现价值点。1数据爬虫

明确舆情分析的目的和需求后,筛选数据来源渠道获取用户舆情数据。

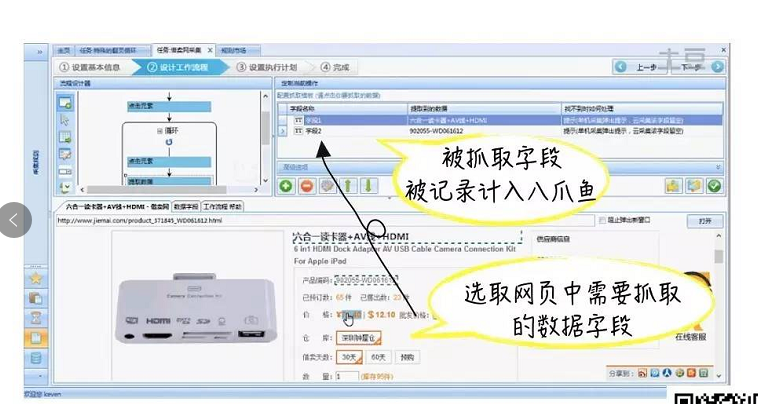

网络上例如论坛发帖、微博评论、淘宝京东的买家评价等文本舆情信息都是可以用爬虫工具直接爬取的。以八爪鱼为例,可以很方便的从网站上把我们需要的内容按二维结构表的形式(比如excel)免费下载保存。如下图所示,八爪鱼就从电商网站商品详情页上爬取到了信息。同理,爬取用户舆情数据也可以采用相同的方法实现。

(图片来源:八爪鱼官网免费教程视频截图,笔者标注)

2文本清洗和预处理

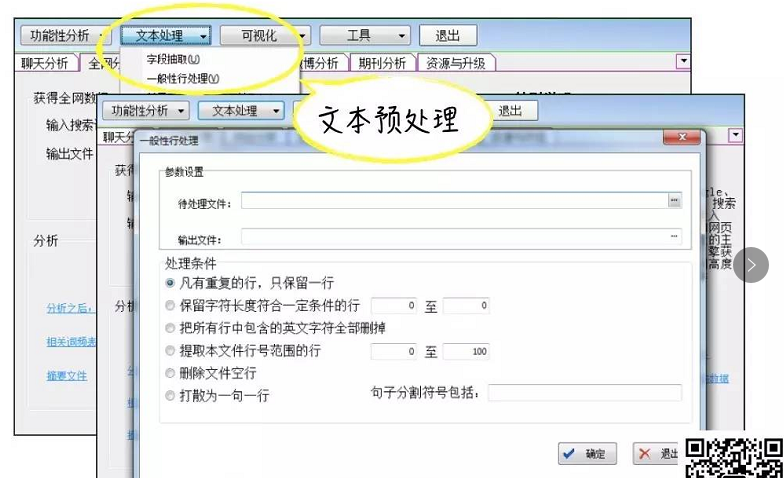

用户在网络上的书写表达非常随意多样,汉字中夹杂数字、字母、符号;语句段落的表达间断不完整,还会出现大量重复的短语短句,比如有的人会评论“棒棒棒棒”“太太太太差了“。文本清洗首要是把这些噪音数据清洗掉。ROST的“文本处理”功能可以用来进行文本清洗。

我们还应根据需要对数据进行重新编码。例如在网易云课堂的某次舆情分析中,用户大量提及了中国大学MOOC,但表达方式有多种(如中M、中国大学慕课、慕课)。为了便于分析,统一编码是非常必要的。

3分词

分词就是把一段中文文本切割成一个个单独的词。中文分词的难点在于书写中文时字词之间并没有明显的间隔或划分,不像英文那样可以根据自然书写的间隔实现基本的分词(如“we are ”可以直接拆分出“we” “are” “”)。

汉字书写表达时没有明显的分隔符,再加上汉语博(那)大(么)精(复)深(杂),大大增加了中文分词的难度。这里举一个经典的例子:短语“南京市长江大桥”中由于有些词语存在歧义,计算机的分词结果可能是“南京市/长江/大桥”,也可能是“南京/市长/江大桥”。我们显然知道第一种情况是正确的,但如果算法还不够完善计算机就可能出错,毕竟两种结果基于汉语构词和语法规则都是说得通的。可见具体在实际进行分词的时候,结果可能存在一些不合理的情况。基于算法和中文词库建成分词系统后,还需要通过不断的训练来提高分词的效果,如果不能考虑到各种复杂的汉语语法情况,算法中存在的缺陷很容易影响分词的准确性。

4词频和关键词

词频就是某个词在文本中出现的频次。简单来说,如果一个词在文本中出现的频次越多,这个词在文本中就越重要,就越有可能是该文本的关键词。这个逻辑本身没有问题,但其中有一些特殊情况需要留意。

最关键的一点就是在关于自然语言的语料库里,一个单词出现的频率与它在频率表里的排名成反比。根据经典“齐夫定律”的定义,假设我对文本进行分词处理并统计了词频,发现词频排名TOP3的三个词分别为“的”、“是”、“它”,那么“的”出现频率应该约为“是”的2倍,约为“它”的3倍。结果就可能会是词频排名靠前的高频词占去了整个语料的大半,其余多数词的的出现频率却很少。

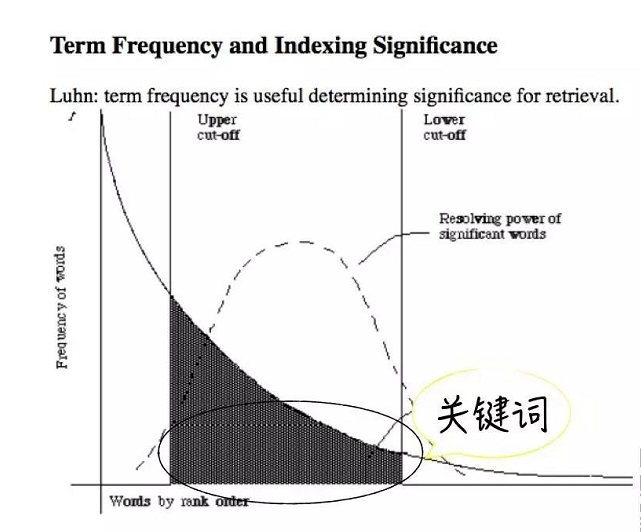

所以不能完全直接的基于词频来判断舆情文本中哪些是重要的关键词,词频最高的其实是中文中的常用字,而非对当前文本最有代表性的关键词。如下图的词频曲线所示,只有出现在曲线中间区域的词才是真正在当前文本中出现频率高,并且在其他文本中很少出现的,这些词语就是当前文本的关键词,对当前文本具有重要性和代表性。前端的高频词和靠后的长尾低频词都可排除在考虑范围之外。

———END———

限 时 特 惠:本站每日持续更新海量各大内部创业教程

站 长 微 信:chuangyedemao

成为VIP

成为VIP